Pourquoi les entreprises doivent s’intéresser au jumeau numérique dès aujourd’hui

Pourquoi les entreprises doivent s’intéresser aux jumeaux numériques dès aujourd’hui

(Grâce à Pixar ! Et pas que pour faire des films !)

Déjà présents, mais peu exploités

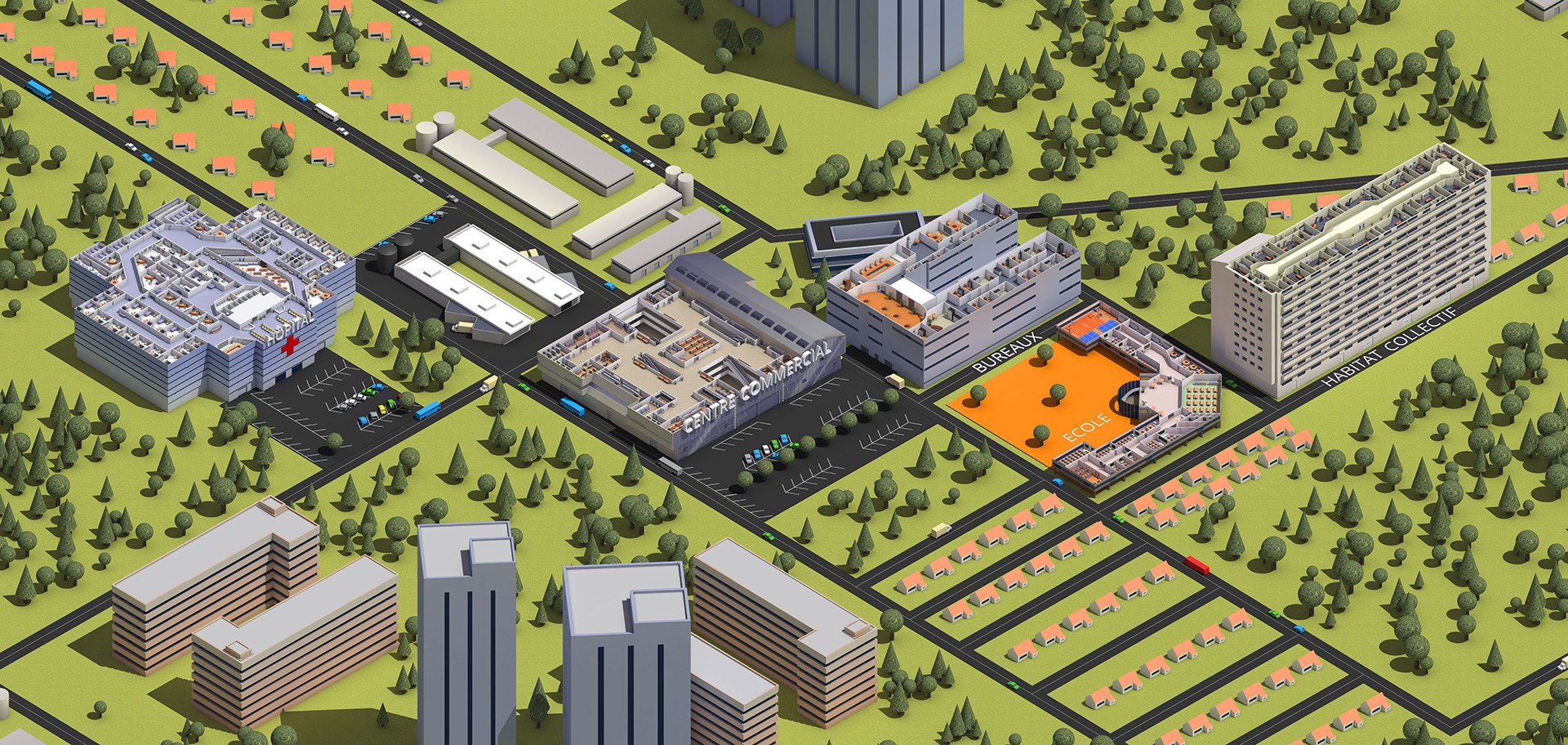

Les jumeaux numériques, « digital twins » en anglais, sont des répliques virtuelles d’objets ou d’espaces physiques.

En prenant du recul sur cette définition Wikipédieste, on se rend compte d’une chose. Les jumeaux numériques sont en fait déjà bien présents dans l’industrie. En effet, il n’y a plus un produit, plus un espace de vente, plus une usine qui n’utilise pas la CAO – Conception Assistée par Ordinateur. (nous en faisions l’objet d’un article).

Bonne nouvelle donc, vous avez déjà des jumeaux numériques et ceux-ci ne demandent qu’à être valorisés. Mais comment faire ? Quels peuvent en être les usages ? Et surtout, pourquoi s’y intéresser aujourd’hui plus qu’hier ?

Précisons d’abord ce que l’on entend par « jumeaux numériques » et ce que l’on peut en attendre.

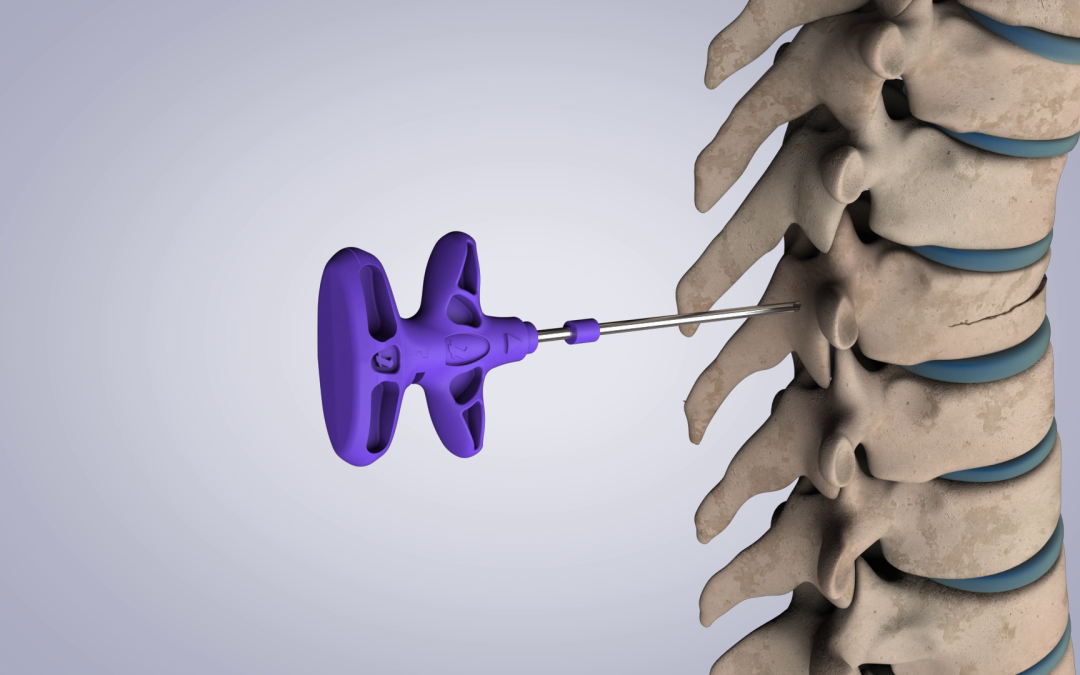

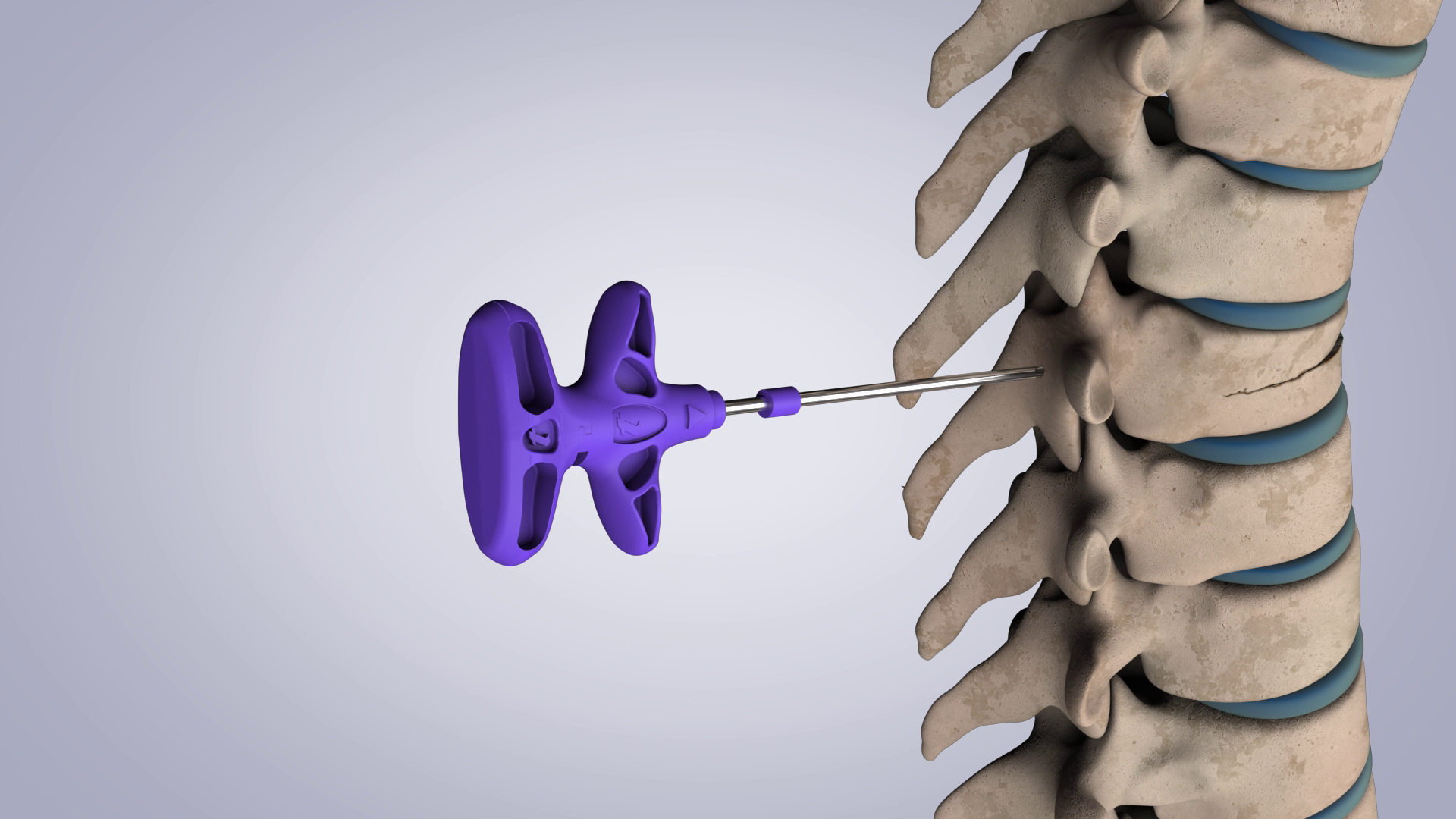

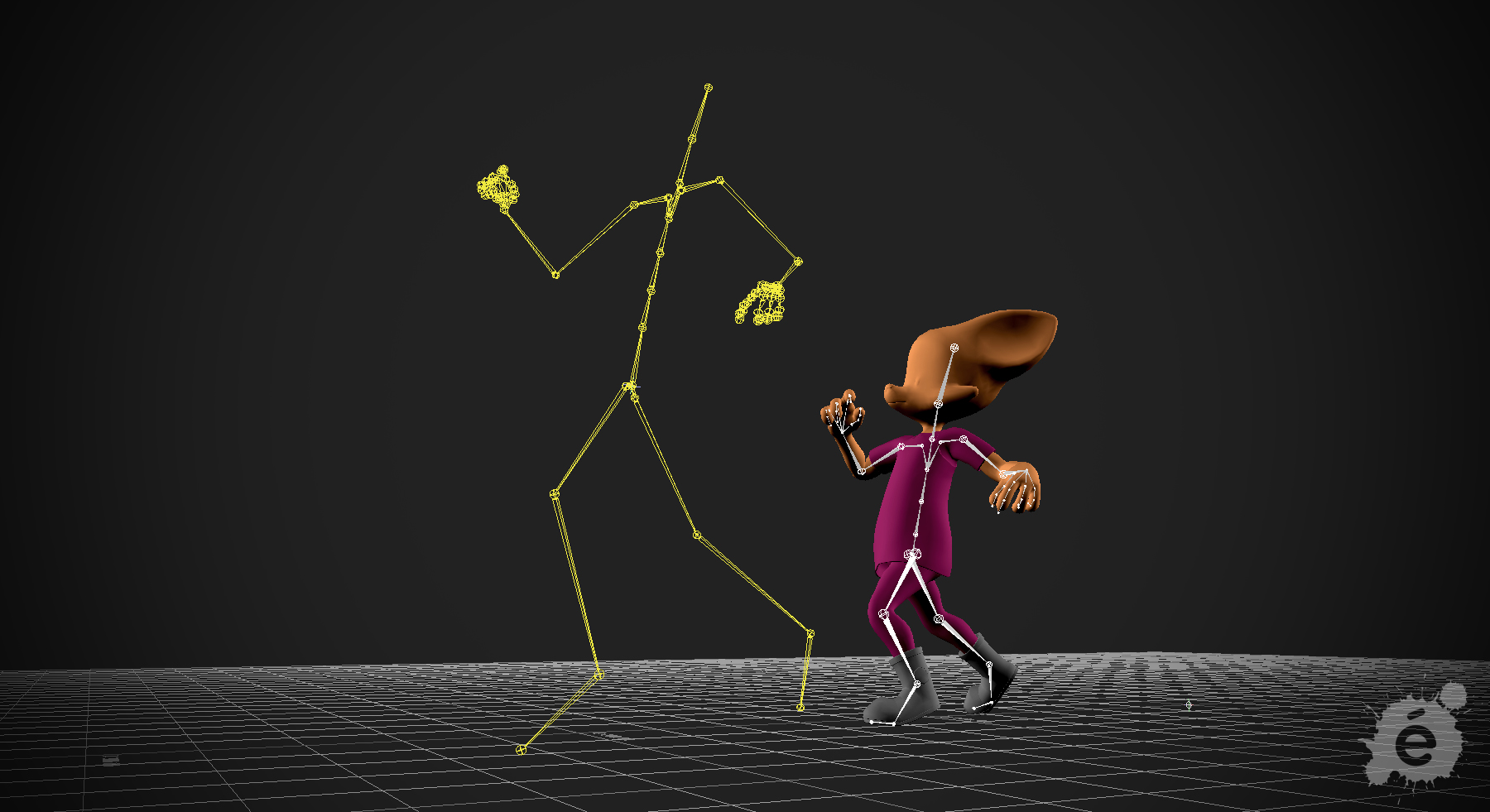

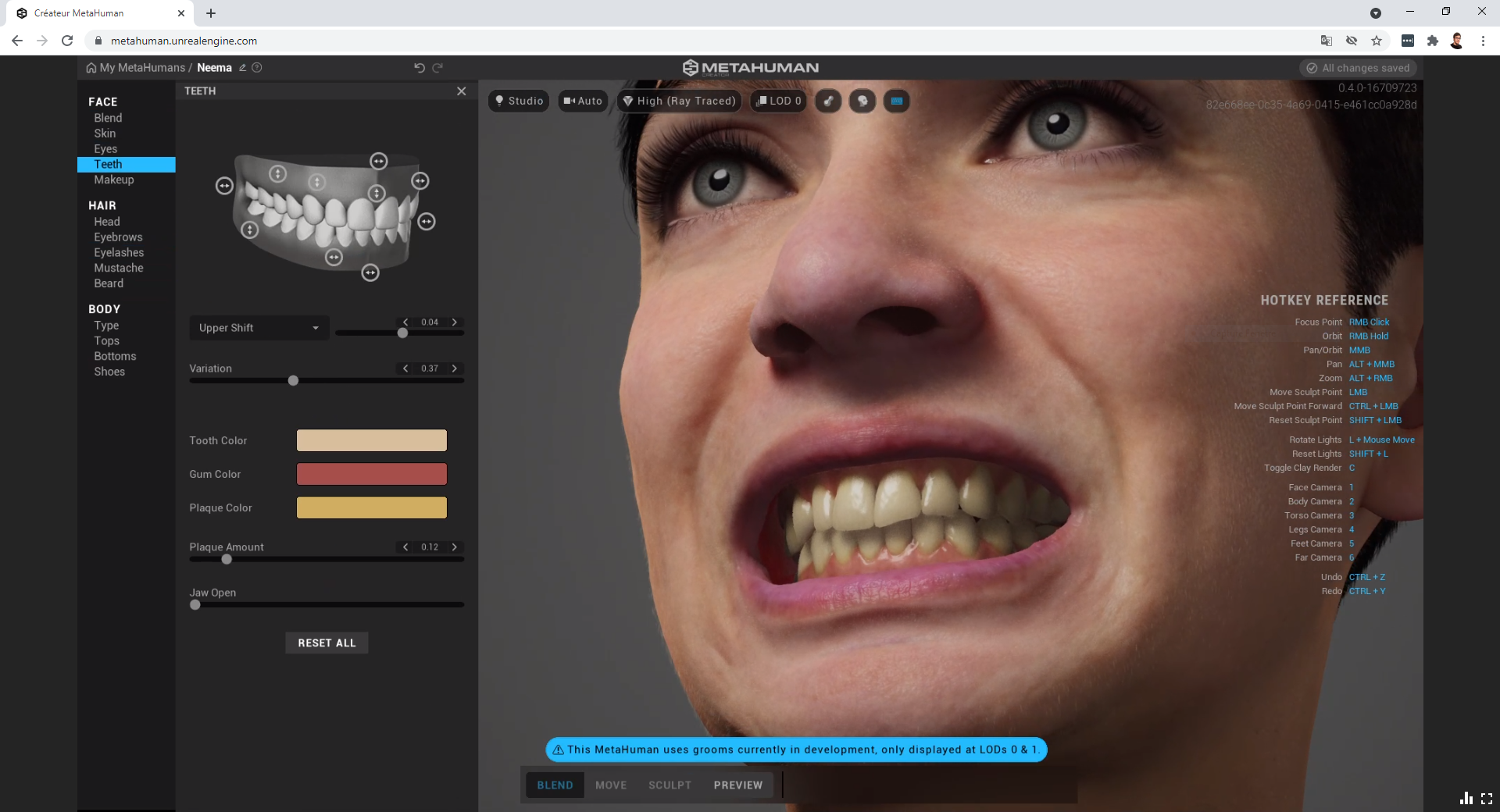

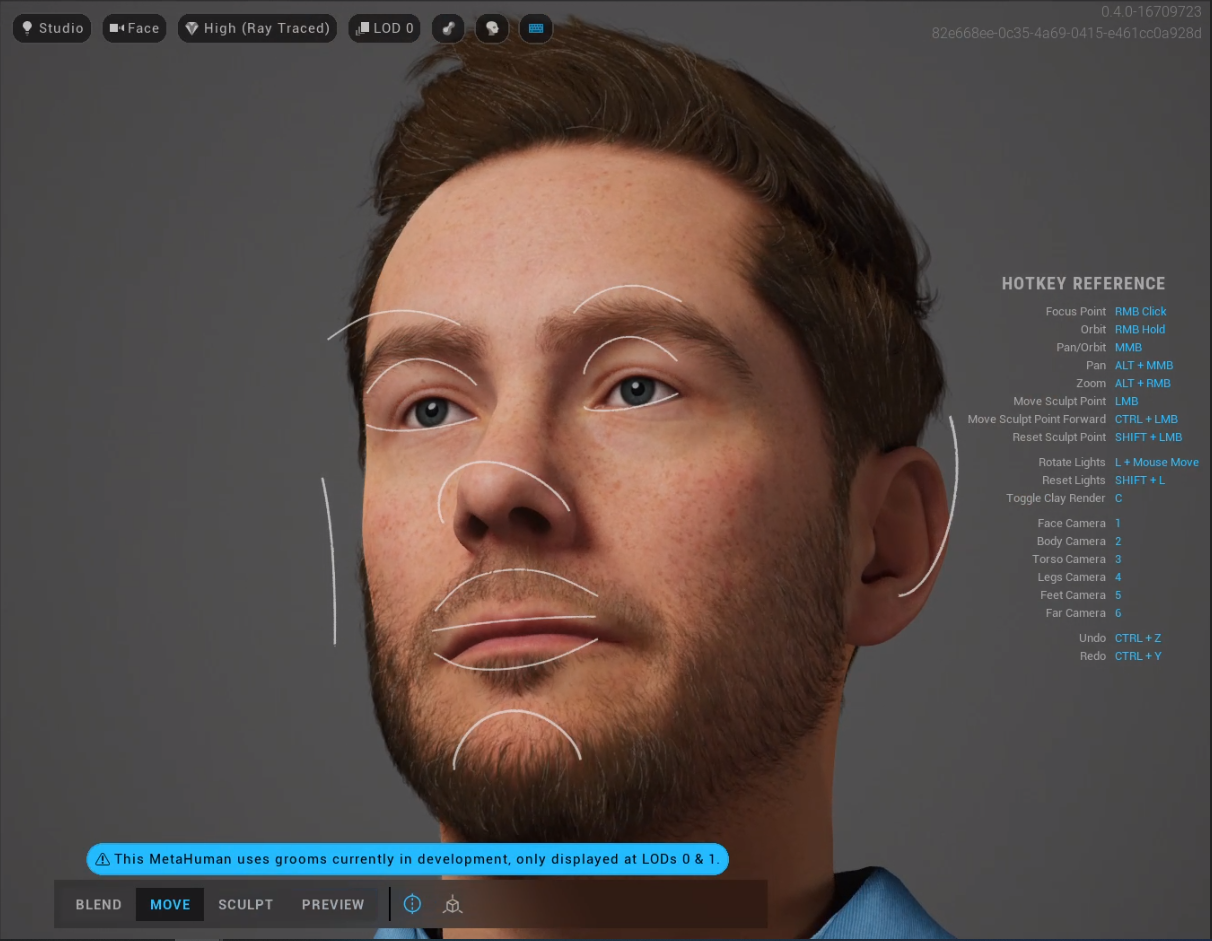

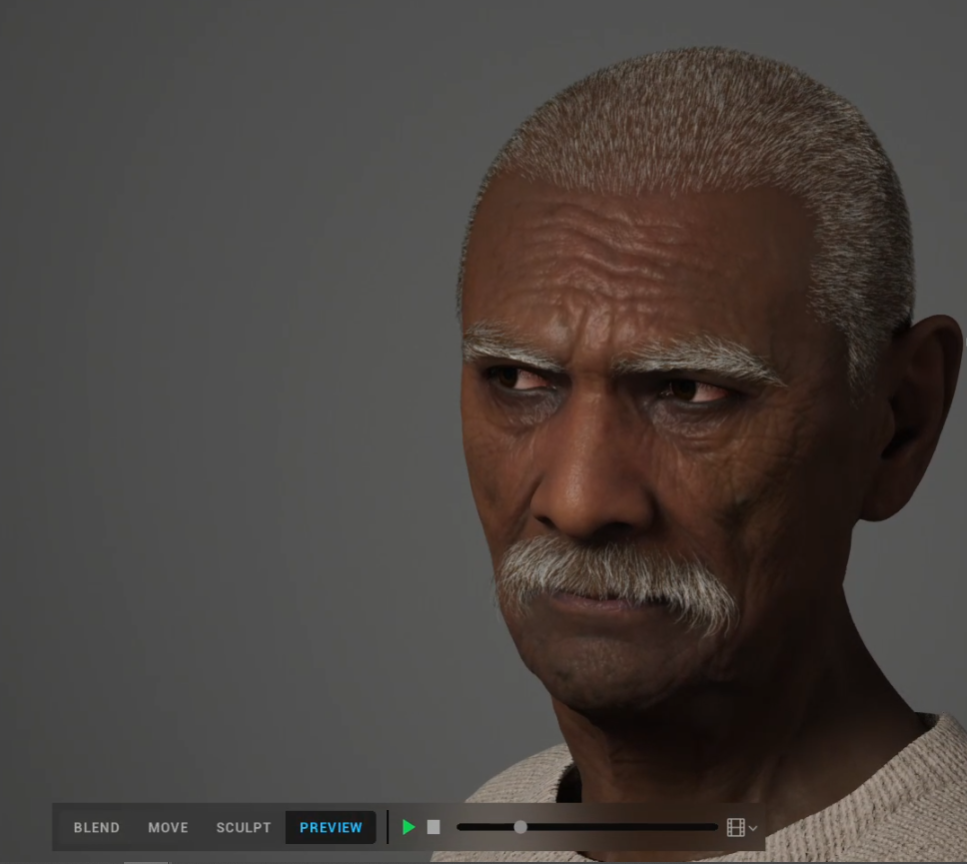

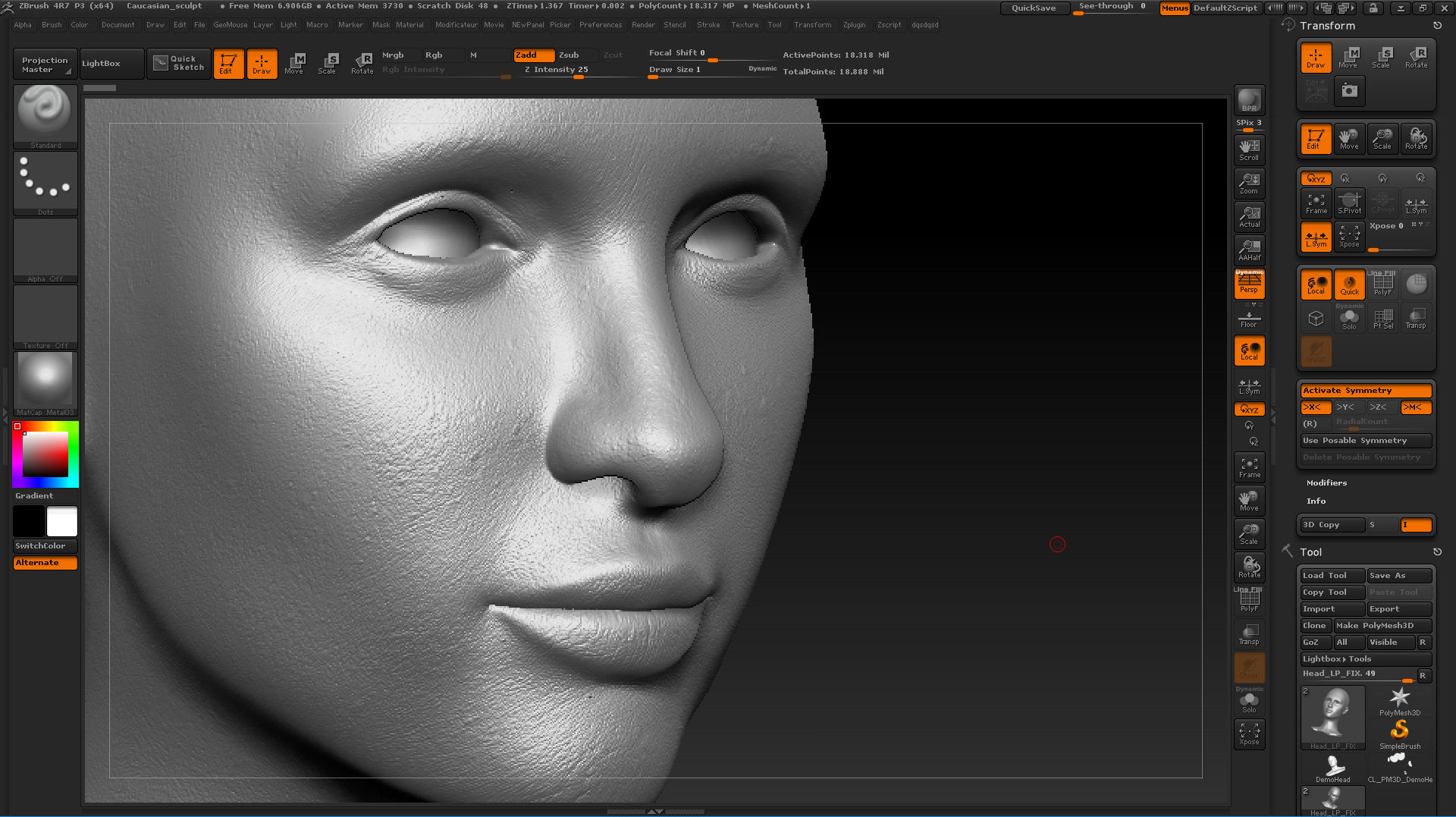

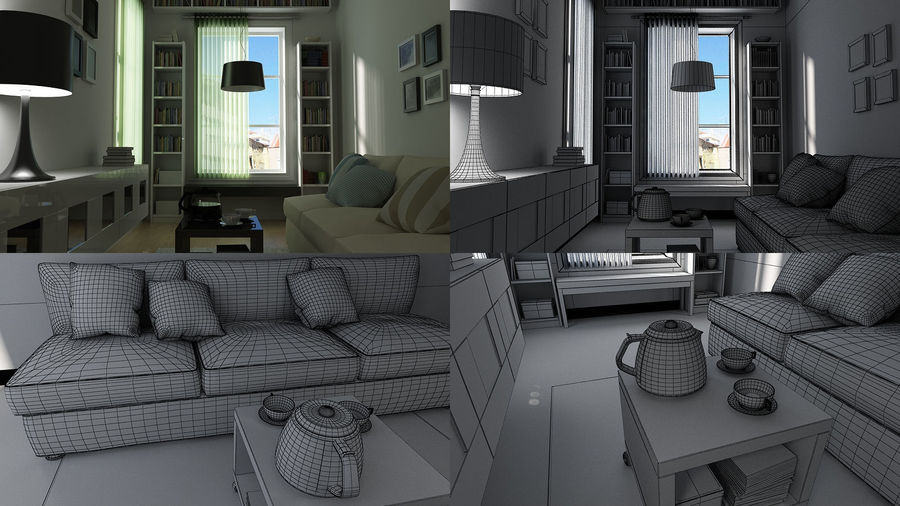

Le jumeau numérique c’est une représentation 3D, une sculpture virtuelle d’un objet ou d’un espace. Cette sculpture est le minimum nécessaire dont un industriel ait besoin pour pouvoir passer à la fabrication. Toutefois, elle ne permet pas de représenter fidèlement un objet. En effet, tout produit a également besoin de matériaux, et ces matériaux ont besoin d’être définis sur la 3D. Il faut décider leur aspect, leur granularité, leur comportement à la lumière, afin d’en obtenir un visuel réaliste – voire photoréaliste. C’est la grande différence qu’il y a entre un logiciel de CAO, et un logiciel, dit DCC, d’images de synthèse ou d’applications virtuelles.

Une exploitation diverse

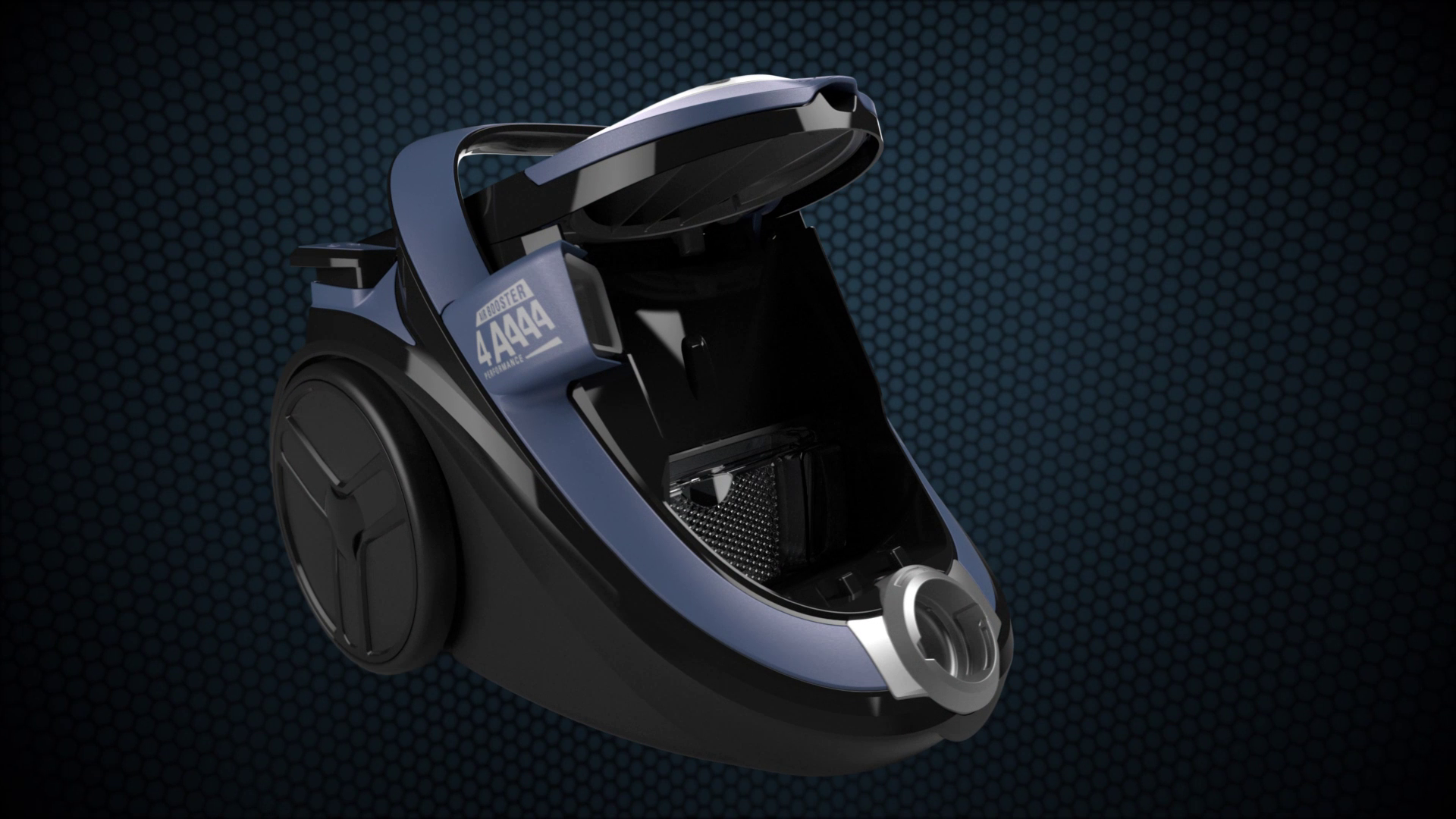

Pendant longtemps, l’usage des jumeaux numériques s’est limité à fournir une belle image de synthèse à des fins de communication. Les enseignes l’ont bien compris. La 3D permet d’obtenir des images propres sans retouche ni détourage pour mettre en scène le produit, souvent, avant même qu’il soit fabriqué. L’exemple le plus connu étant celui du catalogue IKEA, qui propose des images et des aménagements majoritairement en image de synthèse.

Un exemple en vidéo

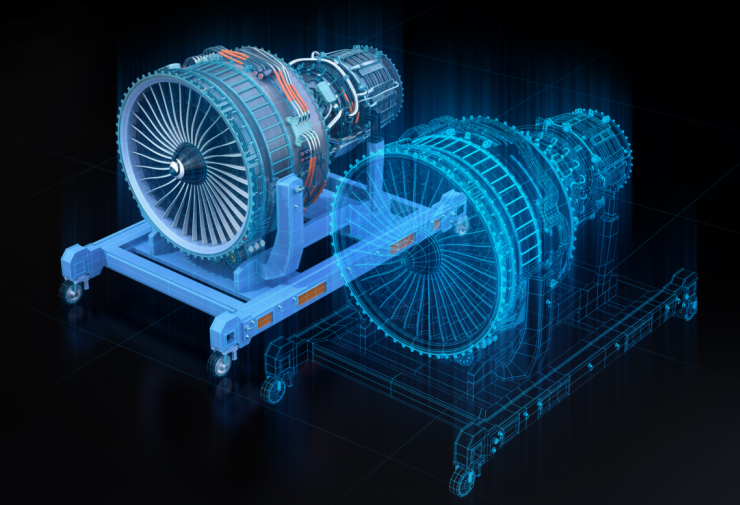

Ici, le jumeau numérique d’une usine de BMW.

En plus de son rôle premier (donner une visibilité complète de la production) les ingénieurs s’en servent pour simuler les étapes de montage des prochains modèles afin de les adapter aux travailleurs, les rendre plus confortables, plus ergonomiques.

En deuxième partie de vidéo, les intervenants montrent également qu’en couplant le jumeau numérique au machine learning, ils permettent à leurs robots d’apprendre toutes les configurations possibles de l’usine pour que les robots puissent mener leurs missions efficacement. Autrement dit : les robots apprennent à s’adapter au réel grâce à des situations virtuelles.

Et même de plus en plus diverse

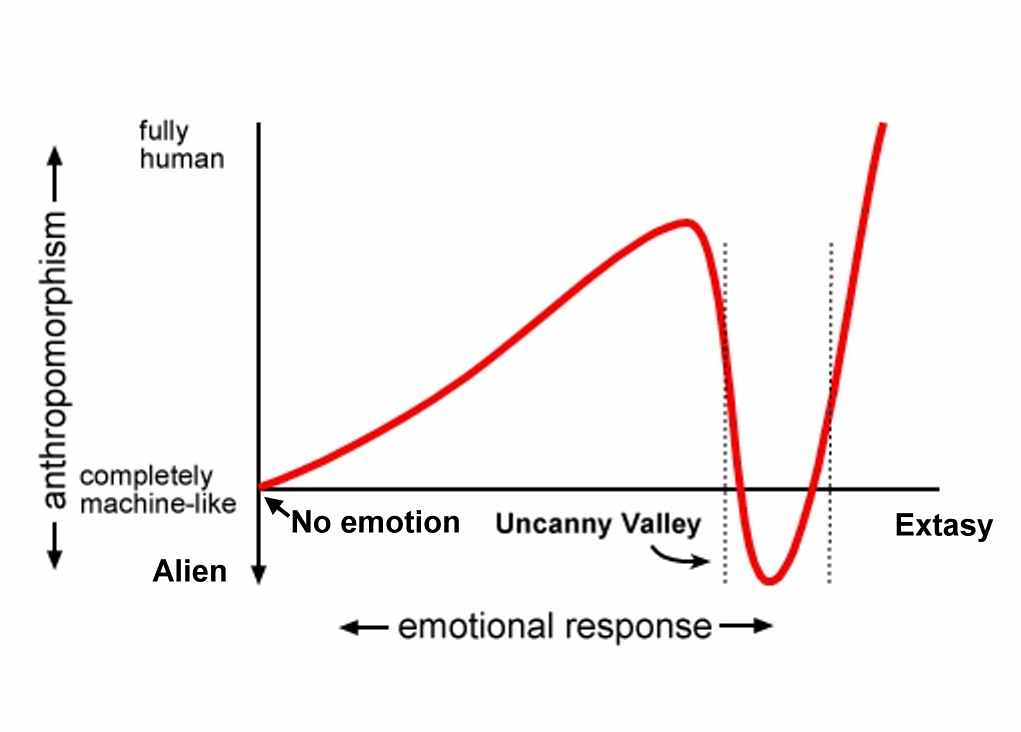

Ces dernières années, certaines technologies ont beaucoup évolué, tandis que d’autres ont vu le jour. Le jumeau numérique profite de tout cela. Aujourd’hui par exemple, grâce à des appareils de plus en plus puissants, des technologies embarquées et un accès rapide à internet, on peut interagir avec notre jumeau numérique directement sur notre smartphone. À cela s’ajoute la réalité augmentée qui apporte de nouveaux champs d’applications : localisation spatiale, agencement in situ, simulation, notice interactive, etc. De son côté, la réalité virtuelle progresse – peut-être moins vite que ce que l’on a pu prétendre, mais à mon avis de manière plus sereine – grâce à des applications orientées business : visite d’un nouveau projet, étude d’ergonomie d’un poste de travail, formation d’une personne selon un scénario, etc. Le Cloud, lui, apporte le stockage, la puissance de traitement et la disponibilité nécessaire pour manipuler ce média, effectivement un peu lourd, qui ne passe pas dans la boîte mail. Enfin, l’évolution rapide de l’intelligence artificielle, surtout dans le domaine de la vision, de la reconnaissance et de la compréhension de son environnement dessine un vaste champ d’applications pour le futur. Alors, pourquoi malgré toutes ces avancées, il est encore difficile de valoriser son jumeau numérique, quand bien même les technologies sont là ?Rouler avec le frein à main

La réponse : parce qu’il n’y a pas de standardisation. C’est là où le bât blesse. En informatique, quand un usage se répand, des formats standards finissent toujours par apparaitre et faciliter les échanges. Imaginez donc le web sans HTML, l’affichage d’images sans JPEG, le partage de document sans PDF, ou la diffusion vidéo sans MPEG4. C’est tout le problème des jumeaux virtuels, ils n’ont pas encore de formats standards. À l’heure actuelle, chaque éditeur de logiciel a son propre format propriétaires. Pire encore, certains logiciels au sein d’un même éditeur ont des formats différents ! Et donc, une fois un jumeau numérique créée dans un logiciel, on peut difficilement le transférer dans un autre. Si aujourd’hui, on parvient sans mal à récupérer la géométrie d’un objet. C’est-à-dire ses faces, ses segments, son maillage. La chose est plus difficile pour les matières ou la hiérarchie d’une scène. Cela implique à chaque fois un gros de travail de reprise et d’adaptation du modèle. Nous-mêmes, lorsque nous reprenons le travail d’un autre studio ou d’un free-lance pour rectifier ne serait-ce qu’une simple illustration sur un produit, ou ajouter une nouvelle teinte, nous savons qu’il ne faut pas espérer recevoir plus que le modèle 3D brut. Ce qui nous laisse souvent 95% du travail à reprendre. Un travail chronophage, donc coûteux, qui mange une grosse partie du budget avant même que nous ayons pu retoucher le modèle pour lui faire gagner en valeur ajoutée. Encore plus si à cela vient s’ajouter une phase de développement spécifique au domaine. Heureusement les choses bougent ! Et dans la bonne direction. En effet, il se joue actuellement une révolution, peu audible certes, mais bien réelle, et qui n’arrive pas forcément par là où on l’attendait.Le GLTF, le JPEG de la 3D

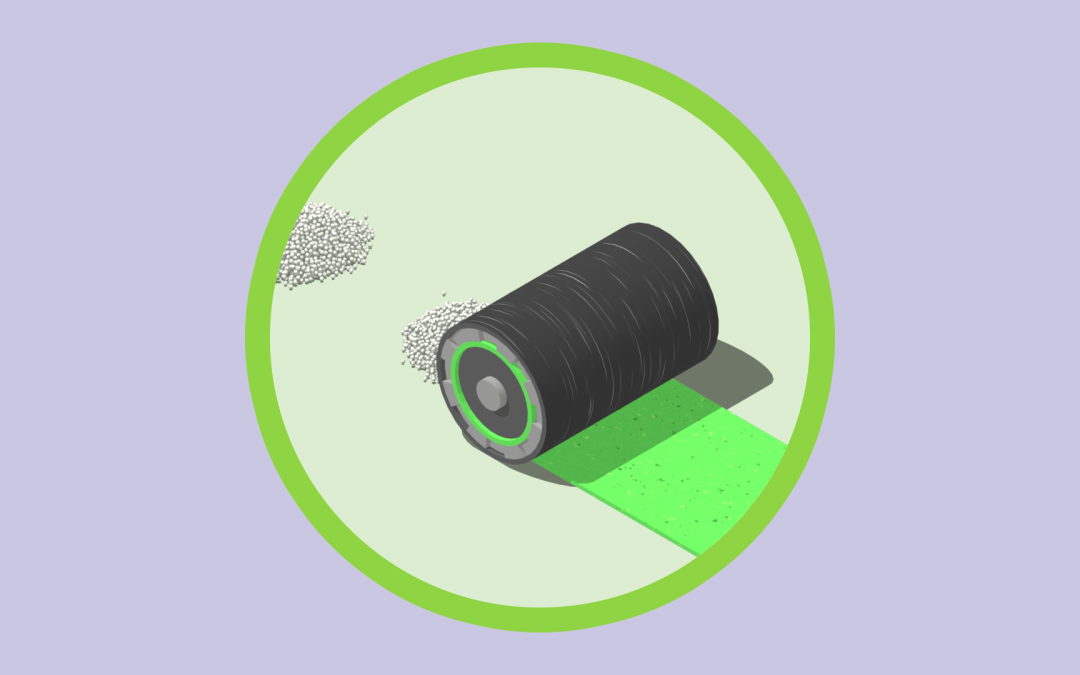

C’est Kronos Groupe, un consortium d’industriel, qui a fait le premier pas vers une standardisation du jumeau numérique. En 2015, ils ont annoncé les spécifications du glTF, un format spécifique aux modèles 3D. Leur travail a ensuite continué pour aboutir en 2017 à une évolution permettant l’intégration de matériaux de manière dite « physiquement plausible ». Traduction : de manière réaliste.

En bref, il est maintenant possible de présenter un produit dans une application ou sur une page Web. Un produit, mais aussi un espace 3D complet si la plateforme cible a les épaules assez solides.

Certes, le glTF n’est pas parfait, car il n’ouvre pas beaucoup les possibilités d’édition – sur ce point, il est comparable au JPEG qui perd les calques ou au PDF dans lequel on ne peut pas modifier le texte – mais il permet au moins de diffuser la 3D à tout le monde, pour que chacun puisse la visualiser de manière interactive, voire interagir avec, sans avoir à installer un logiciel spécifique.

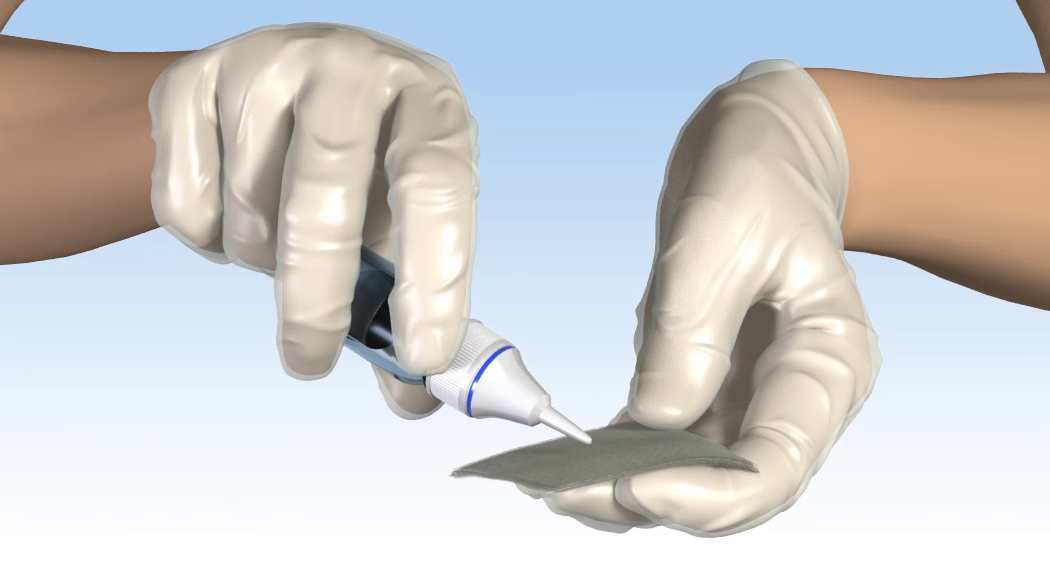

Aujourd’hui, c’est le format que nous préconisons lorsque, par exemple, les utilisateurs d’une application en Réalité Augmentée peuvent eux-mêmes enrichir l’application avec leurs créations.

Preuve que le glTF est pratique : il permet d’intégrer des 3D directement dans notre article

Quand Pixar s’en mêle

L’USD (mais pas les dollars)

L’USD, pour Universal Scene Description, est à la fois un format et une boîte à outils. Il permet d’éditer des scènes 3D : d’ajouter des éléments, changer des matériaux, créer des variantes de certains modèles, composer plusieurs assemblages distincts dans une seule et même scène, animer les éléments, etc.

Omniverse, la boîte à outils

La société NVIDIA, elle aussi, s’est naturellement intéressée à l’USD. Pour ceux qui ne connaissent pas NVIDIA, c’est l’un des plus gros fabricants de cartes graphiques – carte graphiques que l’on utilise pour quoi ? Je vous le donne en mille : pour afficher des scènes 3D ! Bref, en ce qui concerne le matériel, c’est un acteur incontournable de notre métier. Mais pas que. NVIDIA propose aussi la plateforme Omniverse, une boîte à outils géante qui permet l’édition, la manipulation et la visualisation de conceptions 3D. Fondée sur l’USD bien sûr.