La Motion Capture

Notre dernier film, Granpa & Zoé : Mission Lumière, a été l’occasion de ressortir notre combinaison de motion capture – dans le métier on dit « mocap ».

Comme d’habitude, c’est notre animateur qui l’a endossée et a incarné tous les rôles du film. C’est donc une animation maison. Nous faisons tout nous-mêmes. Ce qui ne nous empêche pas d’obtenir des résultats de qualité.

Simplement, pour nous c’est un process différent de celui des grands studios. N’ayant pas les prétentions d’Hollywood, il nous faut travailler autrement, développer une autre organisation.

Le système

D’abord, il faut savoir que nous travaillons avec un système gyroscopique.

Nous expliquions déjà son principe dans notre article sur l’animation. Et pour notre propre santé, nous éviterons de radoter.

Rappelons simplement que lorsque dans un making of, vous voyez un studio cerné de caméra infrarouges avec un acteur en combinaison qui effectue ses mouvements au milieu, eh bien c’est précisément ce qu’on ne fait pas. Il s’agit dans ce cas d’un système optique. Les caméras infrarouges saisissent les mouvements de la combinaison.Dans notre cas, celui du système gyroscopique, c’est la combinaison elle-même qui nous envoie les informations de mouvements. Pas besoin de caméras, ni de studio dédié.

Revenons alors à notre animateur dans sa combinaison.

Nous ne lui demandons pas vraiment de « jouer la comédie » – car il ne donne pas de sa voix – mais plutôt de mimer les personnages.

Quand on fait de l’animation, on a déjà une certaine science du mouvement. On sait caractériser un personnage à travers sa gestuelle, et prêter attention aux détails d’une posture. Bref, on sait parler le body language.

Mais il y a une nette différence entre animer un personnage sur son PC, frame par frame, et le porter en soi. Il faut oublier sa propre gestuelle pour en accueillir une nouvelle. Ce n’est peut-être pas de la comédie totale, mais c’est déjà une forme d’acting.

Un acting un peu particulier d’ailleurs, dans la mesure où on ne peut pas s’appuyer sur les artifices habituels du cinéma ou du théâtre, pour s’aider à entrer dans son rôle. Pas de décor, pas de costume non plus. La combinaison n’en est pas un. Elle peut même produire l’effet inverse, en devenant un attirail un peu encombrant, dont on doit veiller au bon fonctionnement.

Il faut tout imaginer. Se projeter dans une peau et dans un monde en image de synthèse qui n’existent pas encore.

Ou du moins pas complétement. Car on voit quand même notre personnage, dans un rendu sommaire certes, sans finitions esthétique, mais qui permet de juger notre jeu en temps réel. Bien sûr, lorsqu’il joue, l’animateur n’a pas le loisir d’observer ce rendu. C’est son collègue, posté devant le PC, qui le fait pour lui. Il lance l’enregistrement et dirige la session.

D’autres ont la chance d’avoir Spielberg et Peter Jackson pour les guider, c’est bien aussi :

Quels avantages, et quelles limites pour un animateur 3D ?

Ce qu’il faut comprendre alors, c’est que chacun trouvera un intérêt différent dans la motion capture, et louera les qualités qu’il y trouve.

Dans le domaine du jeu vidéo par exemple, là où elle est le plus utilisée, on s’y intéresse d’abord pour sa force mimétique. On s’en sert pour capturer le réalisme des mouvements.

Ce peut être des choses simples en apparence : une discussion entre deux personnages comme ici, ou bien une roulade, une acrobatie quelconque, le mouvement de recharge d’un fusil. Ce peut être aussi des choses complexes qui font suer n’importe quel animateur. Les mouvements d’un cheval par exemple.

Dans ce cas précis, la motion capture rend possible un rêve partagé par tous les animateurs au moins depuis que l’animation existe : aller vers plus de réalisme.

De notre côté, nous utilisons la motion capture pour sa rapidité d’exécution.

Grâce à elle, on peut produire des animations de qualité plus rapidement que si nous les faisions à la main.

De qualité, c’est-à-dire avec un rendu naturel. On cherche à saisir le réel des mouvements comme les petits balancements de bras, les placements non réfléchis de nos mains, la légère inertie de notre corps lors d’une marche. Autant de détails qu’on ne remarque pas lorsqu’ils sont là, mais dont on note aussitôt l’absence, car ils sont la marque du réel. Des détails tous réalisables en animation traditionnelle, mais que la motion capture permet d’obtenir sans même y penser. C’est donc sa rapidité et sa fiabilité qui nous intéresse.

Toutefois, la motion capture n’est pas une solution totale. Elle a ses limites.

D’abord, dans notre cas, elle ne concerne que les personnages. Qui plus est, les personnages ayant forme humaine. Puisque notre combinaison est uniquement adaptée au format humain, inutile de l’essayer sur autre chose.

Si nos personnages ont des membres qui n’appellent pas de mouvements humains, alors la capture n’est plus concernée.

Petite parenthèse : on oublie aussi souvent que la capture ne peut pas tout prendre en charge sur le personnage lui-même. Quid du visage par exemple ? Si on prend les yeux, un studio comme le nôtre devra les animer à la main. Il existe bien sûr des systèmes d’eye tracking, mais ce n’est pas donné à tout le monde.

Ensuite, même lorsqu’on utilise la capture, on aime repasser en animation traditionnelle, car elle nous donne un contrôle plus fin sur les mouvements. Souvent dans l’intention de leur donner plus d’expressivité. Après tout, nous tenons notre héritage du dessin animé. Nous employons son langage. Celui d’une animation vivante, exagérée, qui bascule parfois dans le cartoonesque. Et cela, la Motion Capture ne peut pas nous le donner.

Des étapes supplémentaires, en plus de l’enregistrement

Ok, elle est rapide. Ok, elle est efficace. Mais attention, la motion capture n’est pas automatique. Il ne suffit pas de s’enregistrer avec la combinaison pour produire des animations parfaites.

C’est un outil qui s’apprivoise, qui se règle, et qui exige de passer par plusieurs phases. Disons qu’en plus de l’enregistrement lui-même, on peut distinguer deux autres étapes.

Le retargeting d’abord

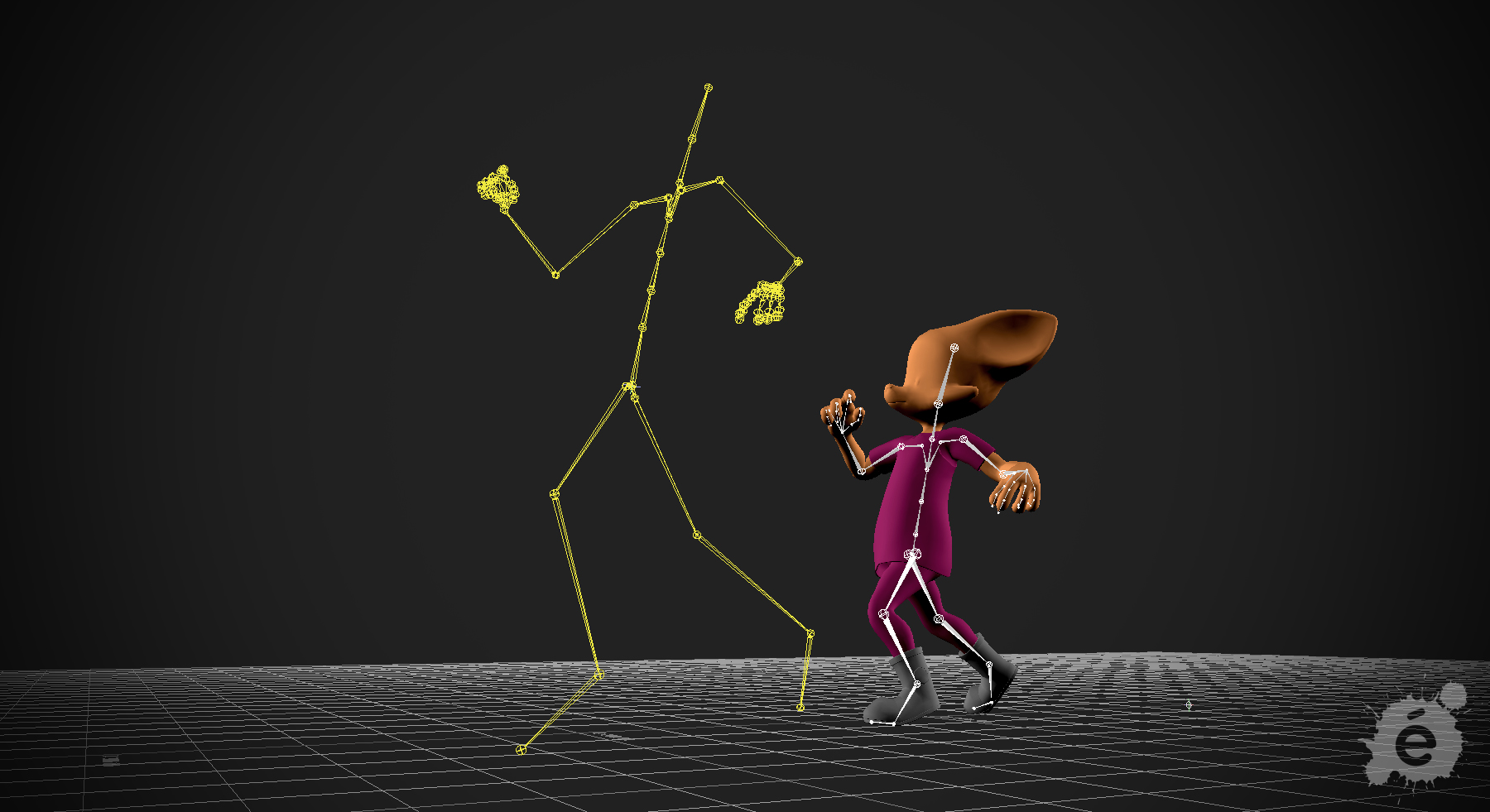

Une fois le personnage créé, si on veut l’incarner, il faut d’abord le lier à nos propres mouvements. Cette étape c’est le retargeting, ou reciblage. Reciblage car on redirige des points d’un squelette à un autre.

En animation 3D, un squelette c’est un ensemble de segments et de points liés les uns aux autres, et hiérarchisés de sorte qu’un mouvement en entraine d’autres. Par exemple, si on bouge le haut d’une jambe, tout ce qui prolonge cette jambe bougera aussi : le fémur, le tibia, et le pied.

C’est peut-être une évidence dit comme ça, il n’empêche que c’est ainsi que se construit un personnage animé. Avec le retargeting, ce qu’on fait, c’est transférer cette hiérarchie. Ou plus précisément : on lie les articulations et les os de notre personnage à notre combinaison.

Heureusement, avec nos logiciels, l’étape est devenue presque automatique. Du moins, elle est plus facile, car on n’a pas à tout transférer nous-mêmes. Il suffit seulement de renseigner le logiciel sur la nature d’un ensemble. Ceci est la jambe droite, ceci est le bras gauche, ceci est le dos, et le logiciel fait le reste.

Mais c’est sans compter les différences qui vont se présenter entre le squelette source de la combinaison, et celui du personnage. Souvent des différences de proportions.

Prenons l’exemple de Zoé

Bien entendu, le retargeting n’est qu’une étape qui permet de raccrocher notre personnage à nos mouvements. L’essentiel surtout, c’est d’avoir bien construit son personnage pour que chaque mouvement soit bien opéré (et ça c’est une autre histoire, celle du rigging).

Ensuite le nettoyage

Il faut comprendre une chose. En motion capture, si le mouvement est immédiatement retranscrit, il n’est pas immédiatement exploitable. Il y aura toujours des ajustements et des corrections à effectuer après la capture.

On peut en distinguer trois sortes :

Le verrouillage des pieds au sol

Et de manière générale : le verrouillage de tout ce qui entre en contact avec du dur – c’est le cas lorsqu’un personnage se couche, roule, ou bien s’appuie contre un mur.

Si nous prenons l’exemple de la marche, on verra que lorsqu’on pose le pied au sol, le logiciel de capture ne comprend qu’une chose : que ce pied est immobile. Mais il ne sait pas ancrer ce pied sur le sol, qui pourra alors se décaler légèrement, ou bien à l’inverse entrer à l’intérieur du sol. Ce que nous faisons alors, c’est définir le niveau du sol puis fixer le pied sur ce niveau, et le tour est joué.

Les bruits

Toutes les erreurs dues aux proportions du personnage

Ainsi qu’aux distance vis-à-vis du décor.

Pour la proportion, l’exemple classique, c’est celui du personnage au corps trop grand ou trop gros, si bien que lorsque l’acteur repose les bras le long du corps, les proportions n’étant pas les mêmes entre lui et le personnage, les bras de ce dernier lui entrent dans le corps.

Le problème est de même nature pour les distances.

Lors de l’enregistrement, on essaie de faire attention aux déplacements dans la scène. Si le personnage doit se rendre d’un point A à un point B, on veille à ce que la distance parcourue par le comédien colle à celle imposée par la scène 3D. On prévient ainsi les collisions avec le décor. Mais nombreux sont les cas trop précis pour être correctement ajustés au moment de capture. Ils sont ajustés après coup.

Imaginons par exemple que le personnage doive attraper un objet, il devra avancer son bras. Dans la capture on effectue le mouvement d’approche vers ce dernier. Mais il y a de grande chance que dans la scène 3D ce mouvement soit imprécis, que le personnage soit un poil trop près ou trop loin. On ajustera.

De même qu’on ajustera le geste de saisi. Pour que les doigts se ferment correctement autour de l’objet, et que l’objet soit verrouillé dans la main, on repassera par l’animation keyframe.